ACTUALITÉS

A bout de NeRFs

Vous avez sans doute entendu parler des NeRFs. Ne vous méprenez pas, il ne s’agit pas de pistolets factices aux munitions en mousse, mais de Neural Radiance Fields ou en français « champs de radiance neuronaux ». Derrière ce nom quelque peu énigmatique se cache une véritable révolution dans le monde de la vision par ordinateur et de l’apprentissage automatique.

Après avoir chamboulé le monde de la recherche, elle s’étend aujourd’hui aux industries audiovisuelles. Des effets spéciaux aux jeux vidéo en passant par la préservation du patrimoine, ses applications semblent à première vue nombreuses et prometteuses. Alors que sont les NeRFs ? À quelles problématiques répondent-ils ? Quelles conséquences à court et long termes sur nos industries ? Levons le voile !

Synthèse « inverse » d’images vs synthèse par « simulation »

Pour comprendre les NeRFs, il faut d’abord faire un bond en arrière et se tourner vers un problème majeur de la vision par ordinateur : la synthèse d’images (Novel View Synthesis en anglais). Par là, je n’entends pas le rendu tridimensionnel appliqué dans les domaines de l’animation ou les effets spéciaux. Ce dernier relève davantage de l’informatique graphique et repose sur un long processus de modélisation 3D, d’édition de textures, de mise en scène, de description du transport de la lumière, etc. Comme l’énumération précédente le laisse entendre, ce processus de synthèse d’image « par simulation » requiert de nombreux efforts en termes de temps, de coûts, de recherche, etc. Le défi est d’ailleurs d’autant plus grand quand un degré important de photoréalisme ou de fidélité physique est recherché.

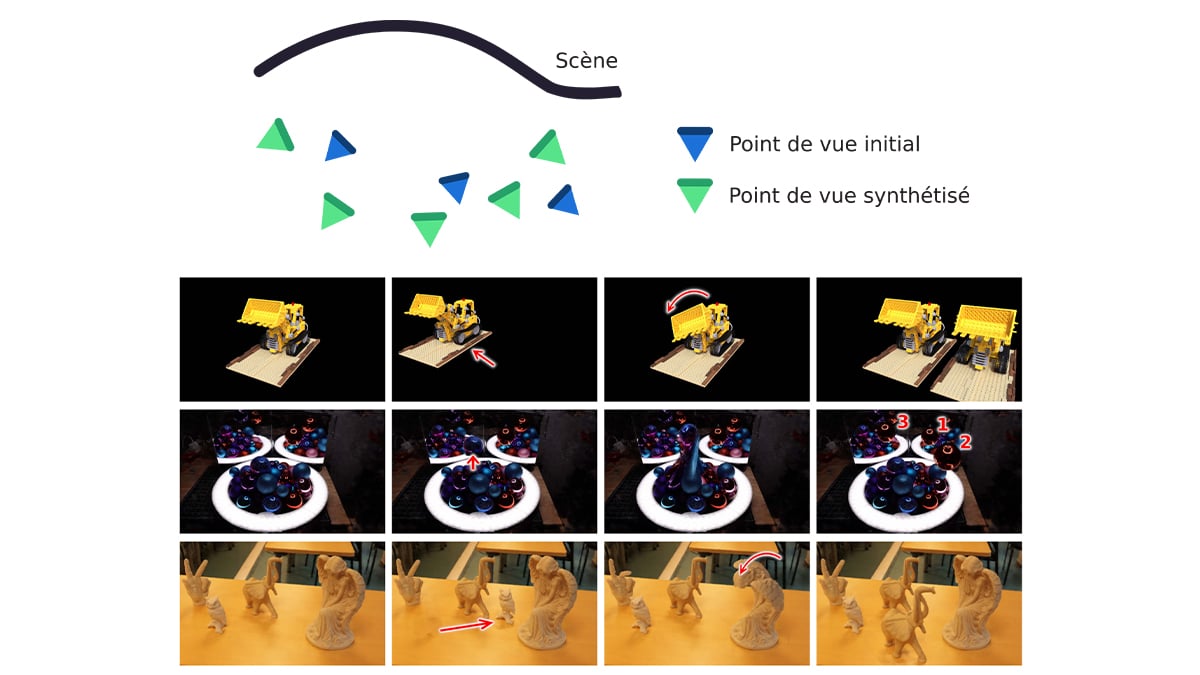

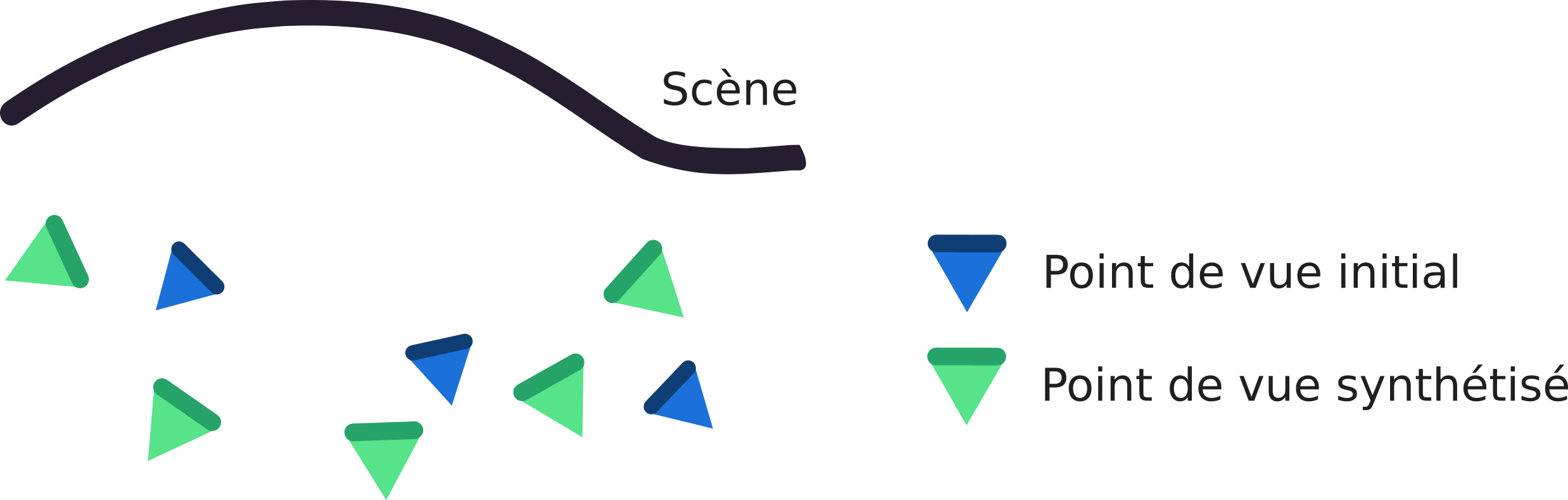

Figure 1 : À partir d’un nombre limité de prises de vues initiales, la synthèse d’images vise à synthétiser arbitrairement n’importe quel point de vue de la scène.

Par conséquent, l’on s’est tourné vers la question « inverse », à savoir « peut-on synthétiser une scène à partir seulement d’un ensemble restreint d’images de cette même scène ? » Autrement dit, comme schématisé ci-dessus, peut-on obtenir de nouveaux points de vue arbitraires en dehors de ceux capturés sur place à un instant donné ?

Avant d’aller plus loin, il convient de faire une légère distinction avec la photogrammétrie. En effet, cette dernière ne cherche pas à synthétiser des points de vue, mais davantage à reconstituer des modèles texturés qui seront utilisés ultérieurement dans un processus standard de synthèse par « simulation ». Dans la synthèse « inverse », la représentation choisie s’affranchit des contraintes nécessaires à la simulation au profit du photoréalisme. Cette dernière phrase peut sonner quelque peu contradictoire. Plus concrètement, la fonction d’utilité n’est plus « je dois modéliser l’objet et le transport de la lumière parfaitement » mais plutôt « je dois représenter une scène entière et avoir l’air réel, qu’importent les concessions en matière de physique ».

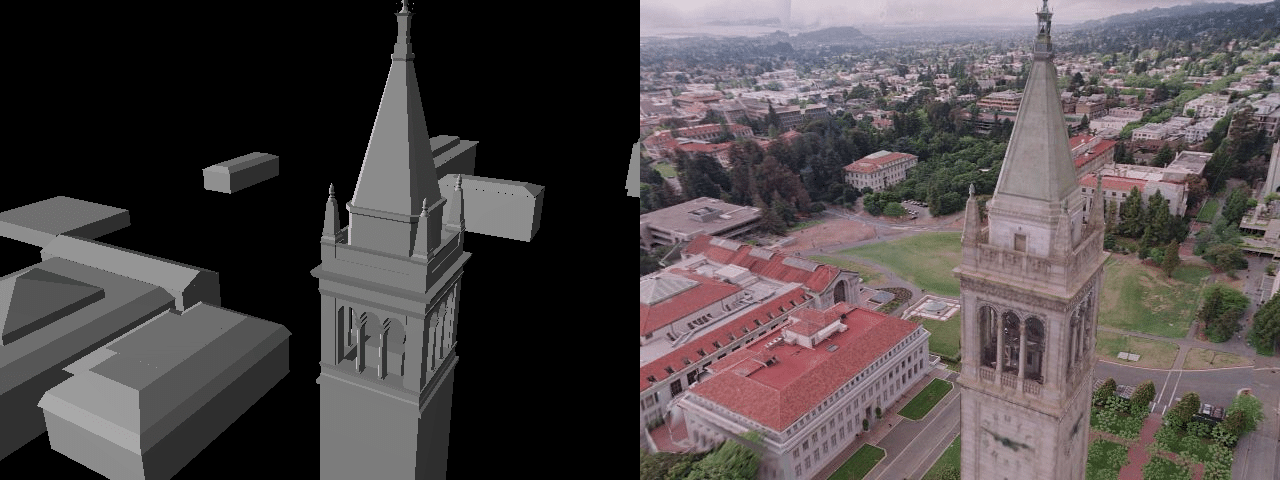

Figure 2 : Maillage de substitution (à gauche) sur lequel sont projetées des images de l’environnement (à droite). Illustrations tirées du court-métrage The Campanile Movie réalisé par Paul Debevec en 1997.

À cet effet, la synthèse d’image s’est longtemps appuyée sur des heuristiques que l’on peut grossièrement catégoriser en trois approches. La première consiste en la reconstitution d’une représentation appelée « proxy » (par exemple un maillage) sur laquelle est projeté l’ensemble des vues capturées de la scène. La seconde vise à synthétiser un point de vue en fusionnant plusieurs vues adjacentes. Enfin, la dernière est une combinaison des deux où le contenu qui est projeté sur le « proxy » guide le processus de fusion. J’attire l’attention du lecteur sur un point : la synthèse telle que décrite existe depuis plusieurs décennies ! À titre d’illustration, Paul Debevec, davantage connu pour ses travaux sur le relighting, a en 1997 dans le cadre de son doctorat réalisé le court-métrage The Campanile Movie dans lequel il a reconstitué un « fly through » autour de la fameuse tour de Berkeley proche de San Francisco. C’est d’ailleurs ce même court-métrage qui aurait inspiré John Gaeta, superviseur des effets spéciaux du film Matrix, pour le fameux « bullet time » du film !

Dans la suite de l’article, retrouvez :

-

Une première révolution, le NeRF

-

Une seconde révolution, Gaussian Splatting

-

Mais Gaussian Splatting sonne-t-il la fin des NeRFs ?

-

Que faire des NeRFs ?

-

Créer du contenu grâce aux NeRFs ?

-

Le mot de la fin

Retrouvez l’intégralité de l’article écrit par Clément Jambon (Maîtrise ès sciences ETH Zurich), dans la Lettre n°187.

Articles récents